Ведущий сбор и анализ данных

Сбор и анализ данных – это, конечно, сейчас на устах. Все говорят об этом, и это понятно – данные стали новым нефтью, как говорится. Но часто возникает ощущение, что все просто: собрал кучу информации, обработал – и вот тебе ценная информация. А на практике, как обычно, все гораздо сложнее. Мы, в ООО Чэнду Хуашэнкун Технологической компании, сталкиваемся с этим ежедневно. Наша компания, основанная в 2011 году и специализирующаяся на разработке интеллектуальных роботов и AI-технологий, постоянно работаем с огромными массивами данных для обучения наших алгоритмов и оптимизации работы робототехнических систем. Причем, не просто собираем, а ведущий сбор и анализ данных, т.е. строим систему, которая позволяет автоматически выявлять, преобразовывать и анализировать большие объемы информации из различных источников. Но это не всегда гладко.

Проблема качества данных

Первая и, пожалуй, самая распространенная проблема – это качество данных. Иногда кажется, что проще вообще не собирать данные, чем потом разбираться с шумом, ошибками и неполнотой. Мы однажды потратили месяцы на анализ данных, собранных с датчиков одного из наших промышленных роботов. Оказалось, что большая часть данных была повреждена из-за неполадок в сенсорах. Это привело к совершенно неверным выводам и потраченным ресурсам. Конечно, это не уникальный случай. Часто бывает, что данные собираются в спешке, без должного контроля качества, или же из-за проблем с оборудованием. Это критически важно понимать, ведь 'мусор на входе – мусор на выходе', как говорится. Мы используем различные методы для проверки и очистки данных, такие как обнаружение выбросов, заполнение пропусков и исправление ошибок. Но это – непрерывный процесс.

Другой момент – разнородность данных. Часто приходится собирать информацию из разных источников: датчиков, логов, баз данных, внешних API. И каждый из этих источников может использовать свой формат и структуру. Это требует значительных усилий для преобразования данных в единый формат, который можно будет использовать для анализа. Мы используем инструменты ETL (Extract, Transform, Load) для автоматизации этого процесса. Но даже с использованием этих инструментов, постоянно возникают новые сложности, связанные с изменениями в форматах данных или появлением новых источников.

Инфраструктура для ведущего сбора и анализа данных

Без надлежащей инфраструктуры ведущий сбор и анализ данных просто невозможен. В нашей компании мы используем комбинацию облачных и локальных ресурсов. Облачные платформы, такие как AWS или Azure, предоставляют гибкость и масштабируемость, необходимые для обработки больших объемов данных. Но локальные серверы необходимы для хранения критически важных данных и выполнения задач, требующих низкой задержки. Выбор правильной инфраструктуры зависит от конкретных требований проекта, бюджета и уровня безопасности.

Важным компонентом инфраструктуры является система управления данными. Мы используем озера данных (data lakes) для хранения необработанных данных в исходном формате, а также хранилища данных (data warehouses) для хранения структурированных данных, предназначенных для аналитики. Внутри этих хранилищ мы используем различные инструменты для обработки, анализа и визуализации данных, такие как Spark, Hadoop, Python (с библиотеками Pandas и Scikit-learn), Tableau и Power BI.

Особенности работы с данными реального времени

Анализ данных в реальном времени (real-time analytics) – это отдельная тема. Например, в работе наших робототехнических систем, постоянный анализ данных с датчиков в реальном времени позволяет оперативно реагировать на изменения в окружающей среде и оптимизировать работу робота. Это требует использования специализированных технологий, таких как Kafka, Flink или Spark Streaming. Помню, у нас был один проект, где нам нужно было отслеживать состояние производственного оборудования в режиме реального времени. Изначально мы планировали использовать традиционный подход с периодическим сбором и анализом данных. Но потом поняли, что это неэффективно, и перешли на систему сбора и анализа данных в реальном времени. Это позволило нам оперативно выявлять и устранять неполадки, что значительно повысило эффективность производства.

Анализ и интерпретация результатов

Собранные и обработанные данные – это только половина дела. Важно уметь анализировать результаты и делать на их основе выводы. Это требует глубоких знаний в области статистики, машинного обучения и предметной области. Мы часто используем методы машинного обучения для выявления скрытых закономерностей в данных и прогнозирования будущих событий. Например, мы можем использовать модели машинного обучения для прогнозирования отказов оборудования или для оптимизации маршрута робота. Но важно помнить, что модели машинного обучения – это всего лишь инструменты. Они требуют правильной настройки и валидации, чтобы давать достоверные результаты.

При интерпретации результатов важно учитывать контекст и возможные ограничения. Не стоит делать поспешных выводов, основываясь только на данных. Необходимо учитывать другие факторы, которые могут влиять на результаты. И важно постоянно проверять и обновлять свои модели и алгоритмы, чтобы они оставались актуальными и точными. К примеру, когда мы разрабатывали систему прогнозирования нагрузки на производственную линию, очень важно было учитывать сезонность и другие внешние факторы. Если не учитывать эти факторы, то модель может давать неверные прогнозы.

Ошибки и неудачи в сфере сбора и анализа данных

Как и в любой другой области, в сфере сбора и анализа данных случаются ошибки и неудачи. Однажды мы потратили много времени на разработку модели машинного обучения, которая должна была прогнозировать спрос на нашу продукцию. Модель оказалась очень точной в лабораторных условиях, но в реальной жизни она давала совершенно неверные прогнозы. Оказалось, что мы не учли изменения в поведении покупателей и не смогли адаптировать модель к новым условиям. Эта неудача научила нас важности тестирования моделей в реальных условиях и постоянной адаптации к меняющимся условиям.

Еще одна распространенная ошибка – это переусложнение. Иногда разработчики пытаются использовать самые передовые технологии и алгоритмы, не учитывая, что для конкретной задачи может быть достаточно более простых решений. Это может привести к увеличению сложности системы, снижению производительности и повышению стоимости разработки. Мы стараемся придерживаться принципа 'Keep It Simple, Stupid' (KISS) и использовать только те технологии, которые действительно необходимы для решения задачи.

Будущее ведущего сбора и анализа данных

Ведущий сбор и анализ данных будет продолжать развиваться и играть все более важную роль в различных областях. Мы ожидаем, что в будущем будут использоваться более продвинутые методы машинного обучения, такие как глубокое обучение и обучение с подкреплением. Также будут развиваться технологии обработки данных в реальном времени и облачные вычисления. И, конечно, будет расти потребность в специалистах, которые умеют собирать, анализировать и интерпретировать данные. В нашей компании, ООО Чэнду Хуашэнкун Технологической компании, мы активно инвестируем в развитие этих направлений и стремимся быть в авангарде технологического прогресса.

Наша компания, постоянно развиваясь, разрабатывает новые подходы в анализе данных, позволяющие нашим робототехническим системам адаптироваться к изменяющимся условиям и оптимизировать свою работу. Мы уверены, что будущие разработки в этой области откроют новые возможности для автоматизации и повышения эффективности производства. Постоянный мониторинг и улучшение процессов сбора и анализа данных – залог успеха в современном мире.

Соответствующая продукция

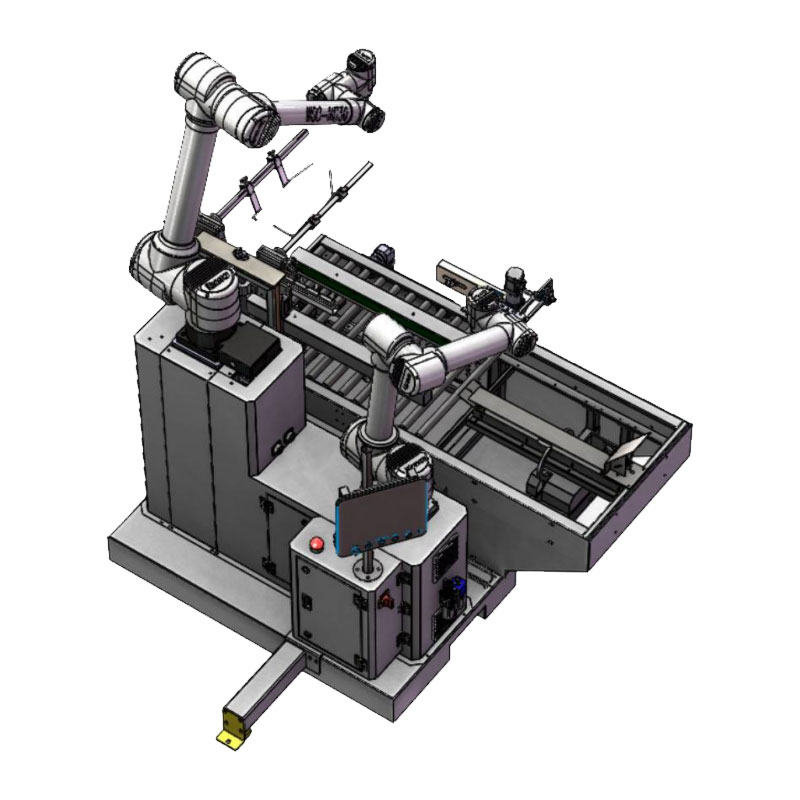

Соответствующая продукция.jpg)

Самые продаваемые продукты

Самые продаваемые продуктыСвязанный поиск

Связанный поиск- Дешевые системы сбора и анализа данных

- Производители автоматизации сортировки

- Купить Гибкая обработка грузов

- Сортировочные роботы в Китае

- Ведущий покупатель паллетирования медицинских товаров

- Фабрика сортировки товаров

- Дешевые роботы для паллетирования

- Ведущая оптимизация стратегии захвата

- Производители датчиков положения

- Ведущий производитель оборудования для параллельного перемещения