Купить Оптимизация стратегии ползания

Купить Оптимизация стратегии ползания – это запрос, который часто встречается в нашей практике. Но обычно, когда люди говорят об этом, имеют в виду просто настройку robots.txt или карту сайта. А это, конечно, лишь верхушка айсберга. Понимаете, это не просто ?попросить поисковик просканировать сайт?. Это целая система, требующая глубокого анализа и постоянной адаптации. И вот где начинаются настоящие сложности. Я думаю, многие компании недооценивают сложность эффективной оптимизации стратегии ползания.

Что такое ползание (crawling) и почему это так важно?

Для начала, давайте разберемся, что такое ползание сайта, или 'crawling'. Это процесс, когда поисковые роботы (пауки) изучают ваш сайт, следуя по ссылкам и собирая информацию. Это фундамент индексации – безползание означает отсутствие индексации. А индексация, в свою очередь, означает, что ваш сайт будет отображаться в результатах поиска.

Но простое ползание – это не гарантия успеха. Если роботы не могут легко находить важные страницы, если сайт перегружен ссылками, если структура нелогична, то поисковик может пропустить ключевые разделы, а значит – и потенциальных клиентов. Поэтому оптимизация стратегии ползания включает в себя не только технические аспекты, но и организацию контента, и оптимизацию структуры.

Мы сталкивались с ситуациями, когда сайт, казалось бы, технически исправен, но имел огромный 'пустой' контент, который забивал индекс. Например, страницы с однотипным описанием продуктов, с одинаковыми мета-тегами и отсутствием уникальных ключевых слов. Это серьезно снижает эффективность ползания, так как поисковику сложно понять, о чем на странице, и какие страницы наиболее важны.

Основные этапы оптимизации стратегии ползания

Давайте рассмотрим основные этапы, которые, на мой взгляд, необходимо учитывать при оптимизации стратегии ползания.

Анализ структуры сайта

Первый шаг – это глубокий анализ структуры сайта. Нужно понимать, как организован контент, какие страницы связаны между собой, как устроены хлебные крошки. Необходимо выявить 'мертвые' страницы, страницы с низким трафиком, страницы с проблемами индексации. Используем инструменты вроде Screaming Frog или Sitebulb, но главное – визуально оценивать структуру. Нельзя полагаться только на цифры, нужно чувствовать, как работает сайт.

Особое внимание стоит уделить внутренним ссылкам. Они – ключевой фактор для улучшения индексации. Нам часто приходится перестраивать внутренние ссылки, чтобы обеспечить логичную навигацию и равномерное распределение веса между страницами. Это трудоемкий процесс, но он действительно приносит результаты.

У нас был один проект интернет-магазина, где внутренняя перелинковка была практически отсутствует. Каждая страница существовала изолированно. После перестройки внутренней перелинковки (добавление ссылок на категории, на популярные товары, на статьи блога) мы увидели значительное увеличение количества проиндексированных страниц и рост органического трафика.

Настройка robots.txt и sitemap.xml

Да, конечно, нельзя забывать про файлы robots.txt и sitemap.xml. robots.txt – это инструкция для поисковых роботов, сообщающая, какие страницы не нужно сканировать. Sitemap.xml – это карта сайта, которая помогает поисковику быстрее и эффективнее найти все страницы. Но здесь важно не просто создать эти файлы, а правильно их настроить.

Важно убедиться, что robots.txt не блокирует доступ к важным страницам. Часто бывает, что случайно заблокируют важный раздел сайта. И sitemap.xml должен быть актуальным и содержать все важные страницы.

Например, один раз мы столкнулись с ситуацией, когда в robots.txt случайно заблокировали всю директорию с PDF-файлами. В результате, поисковик не индексировал важные документы, а трафик на сайт резко упал. Нам потребовалось несколько дней, чтобы найти и исправить эту ошибку.

Оптимизация скорости загрузки сайта

Скорость загрузки сайта – это еще один важный фактор, влияющий на ползание. Поисковики отдают предпочтение быстрым сайтам. Если сайт загружается медленно, роботам сложнее его сканировать. Снова инструменты наподобие PageSpeed Insights помогают выявить проблемные зоны.

И здесь нет универсального решения. Необходимо анализировать сайт и оптимизировать его под конкретные задачи. Это может быть оптимизация изображений, использование кэширования, минимизация CSS и JavaScript.

Мы часто используем CDN (Content Delivery Network) для ускорения загрузки сайта. CDN помогает доставлять контент пользователям с серверов, расположенных ближе к ним географически. Это значительно сокращает время загрузки страницы и улучшает пользовательский опыт.

Сложности и подводные камни

Как я уже говорил, оптимизация стратегии ползания – это не просто настройка параметров. Это сложный и многогранный процесс, который требует постоянного внимания и анализа.

Один из распространенных подводных камней – это переспам ссылками. Если на сайт ссылаются слишком многие сайты, особенно низкокачественные, то это может негативно повлиять на его ранжирование. Необходимо отслеживать обратные ссылки и удалять спам.

Еще одна сложность – это динамический контент. Если на сайте много страниц с динамически генерируемым контентом, то роботам сложнее их сканировать. В таких случаях может потребоваться использование специальных плагинов или скриптов.

В заключение: Постоянная работа

В общем, Купить Оптимизация стратегии ползания – это не одноразовая акция, а постоянный процесс. Необходимо регулярно анализировать сайт, выявлять проблемы и их решать. Поисковые алгоритмы постоянно меняются, поэтому необходимо следить за новыми тенденциями и адаптировать свою стратегию. В конечном итоге, хорошо оптимизированная стратегия ползания – это залог успешного продвижения сайта.

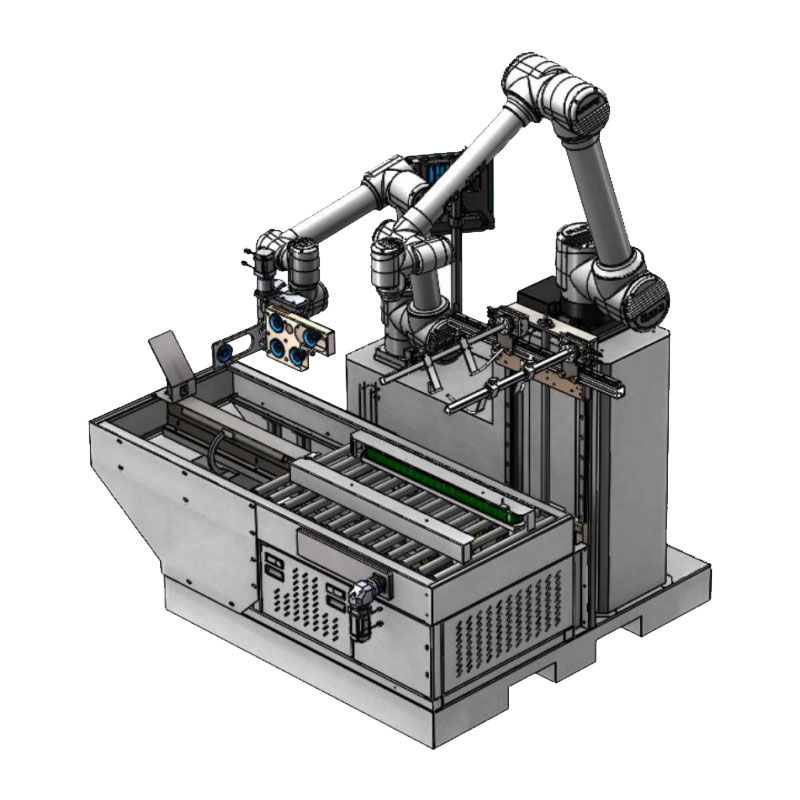

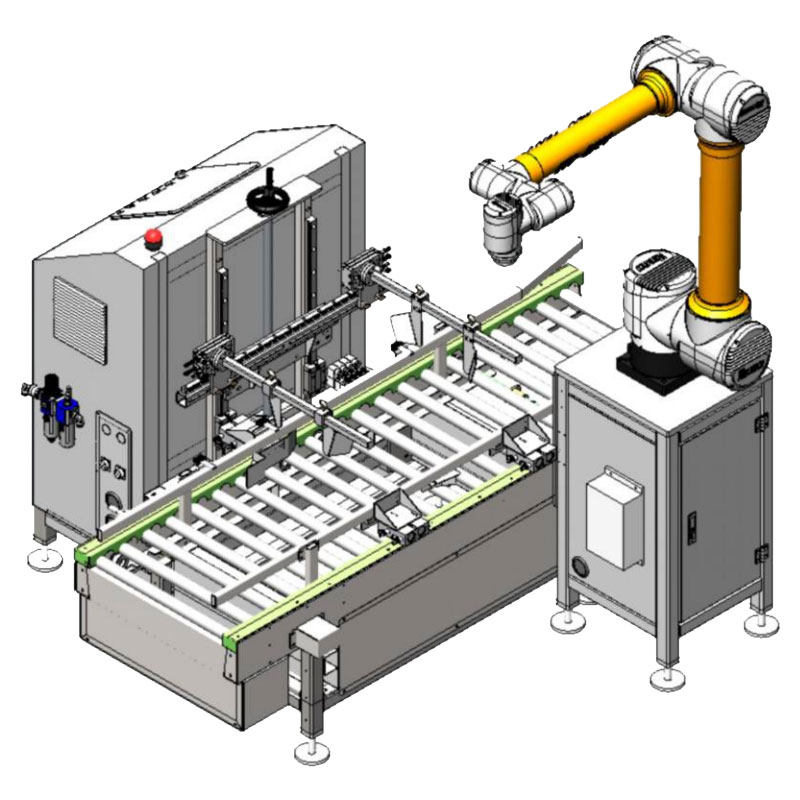

ООО Чэнду Хуашэнконг Интеллектуальные Технологии, как компания, специализирующаяся на интеллектуальных технологиях и робототехнике, понимает важность оптимизации для обеспечения эффективного взаимодействия с поисковыми системами. Мы разрабатываем и внедряем комплексные решения, которые помогают нашим клиентам достигать лучших результатов.

Хотите узнать больше о том, как мы можем помочь вашей компании с оптимизацией стратегии ползания? Свяжитесь с нами по адресу: https://www.warsoncorobot.ru.

Соответствующая продукция

Соответствующая продукция.jpg)

Самые продаваемые продукты

Самые продаваемые продуктыСвязанный поиск

Связанный поиск- Дешевый промышленный интернет

- Машина для упаковки и запечатывания пищевых продуктов в Китае

- Робот для сортировки оптовых партий

- Цены на упаковку в фармацевтической промышленности

- Дешевые автоматизированные производственные линии

- Ведущий покупатель слияния датчиков

- Цены на роботы для картонирования

- Интеллект OEM

- Дельта-робот для сортировки фармацевтических препаратов

- Дешевые Высокая скорость картонирования робот