Купить Сбор и анализ данных

Итак, сбор и анализ данных. Звучит глобально, масштабно, почти как волшебство. Но на деле? На деле это, как и большинство IT-проектов, – это куча деталей, постоянные компромиссы и иногда – ощущение, что ты копаешься в песке, а не в золоте. Многие клиенты приходят с четким видением: 'Нам нужен инструмент, который все сделает автоматически!' И, конечно, они разочаровываются. Потому что идеального инструмента не существует. Тут нужна не просто техника, а комплексный подход, понимание бизнес-задачи и, самое главное – опыт. И вот о чем я хотел бы поговорить – о реальных трудностях, о том, как избежать ловушек и, в конечном итоге, получить ценные результаты от сбора и анализа данных.

Что на самом деле подразумевается под 'сбором и анализом данных'?

Начнем с определения. Для многих это просто 'взять данные из разных источников, потом их обработать и получить отчет'. Но это слишком упрощенно. Сбор данных может включать в себя работу с различными источниками: CRM-системами, базами данных, API внешних сервисов, текстовыми файлами, логами и даже данными, собранными с помощью датчиков IoT. Дальше – **анализ данных**. Здесь уже начинается самое интересное: очистка данных (и это не всегда очевидно!), преобразование, визуализация, применение статистических методов, машинного обучения... В общем, целый арсенал инструментов и техник. И вот где часто возникает хаос – не понимание, какие именно методы подходят для конкретной задачи. Мы часто видим, как компании тратят кучу денег на сложные алгоритмы, которые им на самом деле не нужны. Это как использовать пулемет для перестрелки из пистолета – overkill.

Проблемы с качеством данных: фундамент всего

Я часто сталкиваюсь с ситуацией, когда клиент хочет получить 'волшебный' отчет, а данные – просто ужасны. Разнородность форматов, пропущенные значения, ошибки ввода, дубликаты... Список можно продолжать. Игнорирование проблем с качеством данных – это прямой путь к ошибочным выводам. Вы можете сколько угодно использовать самые передовые алгоритмы машинного обучения, но если данные 'грязные', то результат будет ненадежным. В нашей практике, ООО Чэнду Хуашэнкун Технологической компании (https://www.warsoncorobot.ru) часто приходится тратить значительное время и ресурсы на предварительную очистку и подготовку данных. Иногда это составляет до 80% всего проекта. Это не оптимизм, а реальность.

Практические инструменты и платформы: выбор за клиентом

Рынок инструментов для сбора и анализа данных огромен и постоянно меняется. Существуют решения для разных задач и бюджетов. От простых Excel-таблиц до сложных облачных платформ. Выбор зависит от множества факторов: объема данных, требуемой функциональности, квалификации команды. Например, для небольших проектов может быть достаточно использования Google Sheets или специализированных инструментов визуализации, таких как Tableau или Power BI. Для больших проектов с высокими требованиями к масштабируемости и безопасности лучше выбирать облачные платформы, такие как AWS, Azure или Google Cloud. Мы, например, нередко используем комбинацию различных инструментов: Python (Pandas, Scikit-learn), SQL, Tableau. Важно не зацикливаться на одном инструменте, а выбирать тот, который лучше всего подходит для конкретной задачи.

Отладка: поиск и исправление ошибок – неизбежная часть процесса

Кажется, что все просто – загрузил данные, написал скрипт, получил результат. Но чаще всего – происходит что-то не так. Результаты не совпадают с ожиданиями, скрипт выдает ошибку, визуализация выглядит странно. Отладка – это важная часть процесса, которая требует внимательности и терпения. Нужно уметь читать логи, понимать структуру данных, анализировать результаты. Иногда приходится просиживать ночи без сна, чтобы найти причину ошибки. В нашем случае, мы часто используем системы логирования и мониторинга, чтобы оперативно выявлять и устранять проблемы.

Примеры из практики: успехи и неудачи

Помню один проект, когда клиент хотел разработать систему прогнозирования продаж. Они собрали огромный объем данных о продажах, но данные были неполными и неконсистентными. Мы потратили несколько недель на очистку и подготовку данных, и в итоге получили вполне работоспособную модель. Клиент был доволен результатами. Но был и другой случай, когда клиент хотел получить слишком сложные прогнозы, которые не имели реального практического значения. В итоге, мы решили упростить модель и сосредоточиться на более важных аспектах. Не всегда нужно стремиться к максимальной точности – иногда достаточно получить достаточно точный прогноз для принятия решений.

Проблемы с интерпретацией результатов: не все так просто

И даже если мы получили 'правильные' результаты, не всегда понятно, что они означают. Статистические методы и алгоритмы машинного обучения могут выдавать сложные и непонятные результаты. Важно уметь правильно интерпретировать эти результаты и делать на их основе обоснованные выводы. Это требует не только технических знаний, но и понимания бизнес-контекста. Иногда приходится обращаться к экспертам в предметной области, чтобы понять, какие факторы влияют на результаты анализа.

В заключение, хочу сказать, что сбор и анализ данных – это сложный и многогранный процесс, требующий опыта и знаний. Не стоит ожидать мгновенных результатов и 'волшебного' решения. Это – постоянная работа, требующая внимания к деталям, терпения и креативности. И самое главное – четкое понимание бизнес-задачи и целей. ООО Хуашэнконг Интеллектуальные Технологии постоянно работает над улучшением своих продуктов и услуг, чтобы сделать сбор и анализ данных более доступным и эффективным для наших клиентов. Мы верим, что правильный подход к анализу данных может помочь бизнесу принимать более обоснованные решения и достигать новых успехов.

Соответствующая продукция

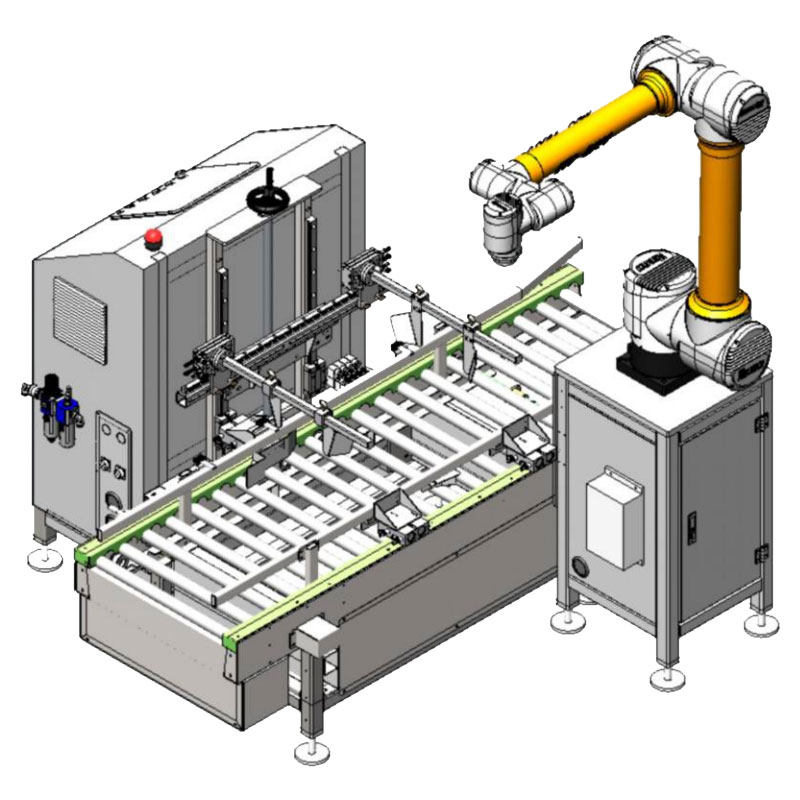

Соответствующая продукция.jpg)

Самые продаваемые продукты

Самые продаваемые продукты-

WSC-MD60Max

WSC-MD60Max -

WSC-MD40Max

WSC-MD40Max -

Высокоскоростная машина для упаковки мягких пакетов

Высокоскоростная машина для упаковки мягких пакетов -

Универсальная машина для распаковки WSC-KZ-RD60T/-RD60B

Универсальная машина для распаковки WSC-KZ-RD60T/-RD60B -

WSC-MD25PRO

WSC-MD25PRO -

Чжихуа WSC-1400D 1600D

Чжихуа WSC-1400D 1600D -

Универсальная машина для вскрытия и запечатывания WSC-KZF-RD60T/-RD60B

Универсальная машина для вскрытия и запечатывания WSC-KZF-RD60T/-RD60B -

WSC-MD50Max

WSC-MD50Max -

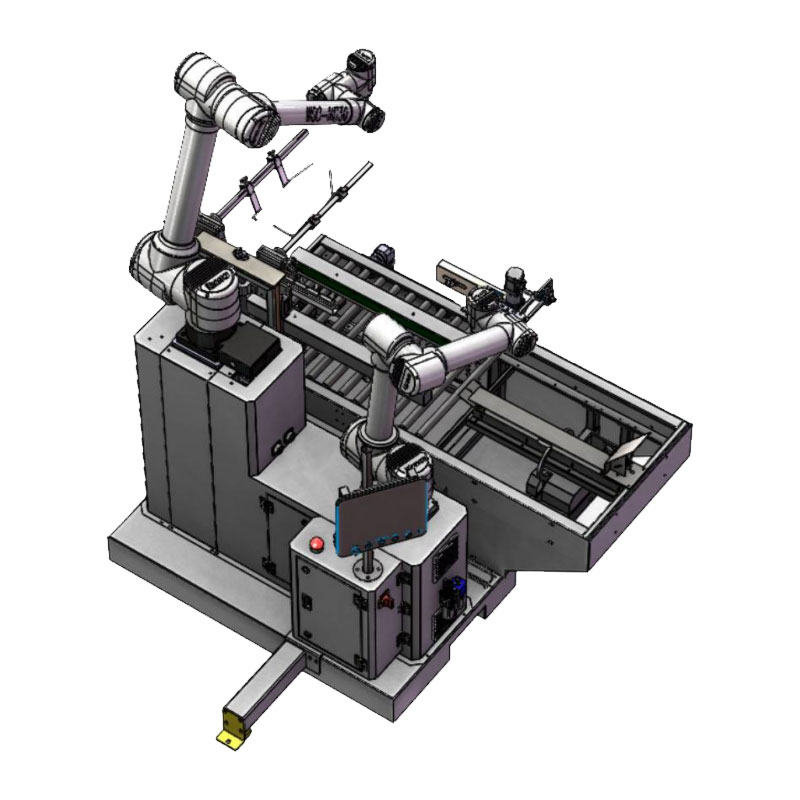

Универсальная коллаборативная машина для вскрытия и установки WSC-KZ-16/25

Универсальная коллаборативная машина для вскрытия и установки WSC-KZ-16/25 -

WSC-ZX1200D

WSC-ZX1200D -

Чжихуа WSC-600D

Чжихуа WSC-600D -

WSC-MD30PRO

WSC-MD30PRO

Связанный поиск

Связанный поиск- Ведущая гибкая обработка грузов

- Оптовая автоматическая горизонтальная упаковочная машина

- Купить Объединение датчиков

- Гибкая автоматизация в Китае

- Оптовый логистический складской центр

- Отличный сортировщик

- Установки для сортировочных роботов

- Превосходные автоматические линии паллетирования

- Слияние визуальных датчиков OEM-робота

- Ведущий покупатель роботов-захватов