Превосходный сбор и анализ данных

Все часто говорят о важности данных, о 'данных как о новой нефти'. И это, конечно, правда. Но ведь просто собрать много данных – это только половина дела. Часто возникает ощущение, что данные есть, но их не хватает для принятия действительно обоснованных решений. Помню один проект – попытка оптимизировать логистику для крупного производственного предприятия. Изначально собрали кучу информации: данные о заказах, поставках, транспортных расходах, даже о погоде. Но при всем этом, результат был… неоднозначным. Ощущение, что мы тонули в цифрах, не понимая, на что именно стоит обратить внимание. И тогда пришло осознание, что проблема не в объеме, а в качестве и в правильности анализа. Нам явно не хватало понимания предметной области и достаточного внимания к деталям.

Проблема качества данных: скрытые ловушки

Пожалуй, самым распространенным заблуждением является уверенность в абсолютной достоверности собираемых данных. На практике, качество данных часто оставляет желать лучшего. Это могут быть опечатки, несоответствия форматов, пропущенные значения, а иногда – и сознательные манипуляции. В нашем случае с логистикой, оказалось, что в данных о времени доставки были систематические ошибки, связанные с неправильной настройкой GPS-трекеров. Небольшая ошибка в этих данных могла привести к совершенно неверным выводам и, как следствие, к неэффективным решениям. Впрочем, это не уникальный случай. В сфере автоматизации производства, например, часто сталкиваемся с проблемой некорректной работы датчиков и систем сбора данных. Неправильная калибровка, влияние внешних факторов, просто износ – всё это может привести к серьезным искажениям в данных.

Не стоит забывать и о проблемах с интеграцией данных из разных источников. Часто данные хранятся в разрозненных системах, с разными форматами и структурами. Сбор и объединение этих данных – это отдельная и зачастую трудоемкая задача. Нужно понимать, как обеспечить их согласованность и не допустить возникновения противоречий. Вот здесь и приходят на помощь инструменты ETL (Extract, Transform, Load), которые позволяют автоматизировать этот процесс. Мы, например, использовали Informatica PowerCenter для интеграции данных из CRM, ERP и WMS систем. Хотя это и требует определенных инвестиций, в долгосрочной перспективе это позволяет значительно повысить качество и доступность данных.

Важность профилирования данных

Прежде чем приступать к сложному анализу, необходимо провести тщательное профилирование данных. Это процесс изучения данных с целью выявления их структуры, качества и возможных проблем. В процессе профилирования можно обнаружить дубликаты, аномалии, некорректные значения и другие несоответствия. На основе результатов профилирования можно принять меры по очистке и улучшению данных. К сожалению, многие компании пренебрегают этим этапом, и потом жалуются на низкое качество результатов анализа. Это как пытаться построить дом на шатком фундаменте.

Выбор правильных инструментов для сбора данных и анализа данных

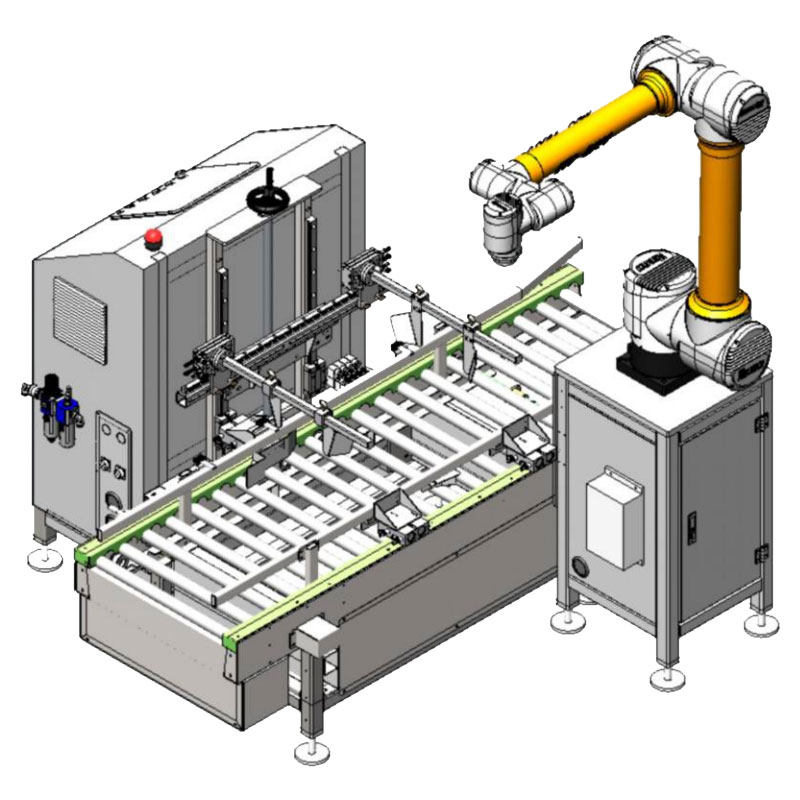

Выбор инструментов для сбора данных и анализа данных – это задача, требующая взвешенного подхода. Существует огромное количество различных инструментов на рынке, каждый из которых имеет свои сильные и слабые стороны. Важно учитывать специфику решаемой задачи, объемы данных, бюджет и другие факторы. Для сбора данных можно использовать различные сенсоры, датчики, API и веб-скрейперы. Для хранения данных – базы данных (SQL, NoSQL), облачные хранилища, data lakes. Для анализа данных – статистические пакеты (R, Python), бизнес-аналитические платформы (Tableau, Power BI), инструменты машинного обучения (TensorFlow, PyTorch). Например, мы успешно используем Apache Kafka для сбора потоковых данных с производственных линий. Это позволяет нам в реальном времени отслеживать состояние оборудования и выявлять возможные сбои.

Облачные решения и масштабируемость

В последние годы все большую популярность приобретают облачные решения для сбора и анализа данных. Они предлагают ряд преимуществ, таких как масштабируемость, гибкость, экономичность и доступность. Облачные платформы позволяют быстро развернуть инфраструктуру для сбора и анализа данных, не беспокоясь о ее обслуживании и поддержке. К тому же, они позволяют легко масштабировать ресурсы в соответствии с потребностями бизнеса. Например, ООО Чэнду Хуашэнкун Технологической компании активно использует Amazon Web Services (AWS) для хранения и анализа данных, полученных с производственных линий и интеллектуальных роботов.

Реальные примеры и ошибки

Были и не очень удачные попытки. Однажды мы пытались разработать систему прогнозирования спроса на продукцию на основе исторических данных о продажах. Использовали сложные алгоритмы машинного обучения, но результат оказался не очень впечатляющим. Оказалось, что мы не учли влияние внешних факторов, таких как экономическая ситуация, сезонность и маркетинговые акции. В итоге, система давала неточный прогноз, и ее использование приводило к убыткам. Это был ценный урок, который научил нас не забывать о важности предметной области и учитывать все факторы, влияющие на результат. Недостаточно просто хорошо уметь программировать, нужно понимать бизнес-процессы.

Ошибки в выборе алгоритмов

Часто ошибки возникают из-за неправильного выбора алгоритмов. Сложные алгоритмы не всегда являются лучшим решением. Иногда достаточно простых статистических методов, чтобы получить достаточно точный результат. Важно понимать, какие алгоритмы подходят для решения конкретной задачи, и не пытаться применять самые сложные алгоритмы, если это не оправдано. Например, в задачах кластеризации данных, часто достаточно использовать алгоритмы k-means или DBSCAN, а не более сложные алгоритмы, такие как hierarchical clustering или spectral clustering. В конечном итоге, самый простой алгоритм, который работает хорошо, лучше, чем самый сложный алгоритм, который дает плохие результаты.

Будущее сбора данных и анализа данных

На мой взгляд, будущее сбора данных и анализа данных связано с развитием искусственного интеллекта, машинного обучения и больших данных. Мы увидим все больше примеров использования этих технологий для решения различных задач в бизнесе, науке и других областях. Станут более доступными и удобными инструменты для сбора, хранения и анализа данных. Будет расти спрос на специалистов, которые умеют работать с данными и извлекать из них ценную информацию. Причем, не только программистов, но и аналитиков, бизнес-экспертов, которые понимают предметную область.

И, что не менее важно, будет возрастать ответственность за качество данных. Потому что от качества данных зависит качество принимаемых решений, а от качества принимаемых решений зависит успех бизнеса. Поэтому, необходимо уделять внимание качеству данных на всех этапах их жизненного цикла – от сбора до анализа и использования.

Соответствующая продукция

Соответствующая продукция.jpg)

Самые продаваемые продукты

Самые продаваемые продуктыСвязанный поиск

Связанный поиск- Упаковочная линия для товаров повседневного спроса в Китае

- Производство картонной упаковки для продуктов питания и напитков

- Завод с видеороликом о машине для упаковки и запечатывания

- OEM интеллектуальная сортировка

- Ведущий покупатель интеграции конечных линий

- Цены на упаковочные машины

- Поставщики складского хранения и логистики

- Производители оборудования для обработки и упаковки пищевых продуктов

- Отличный сортировщик

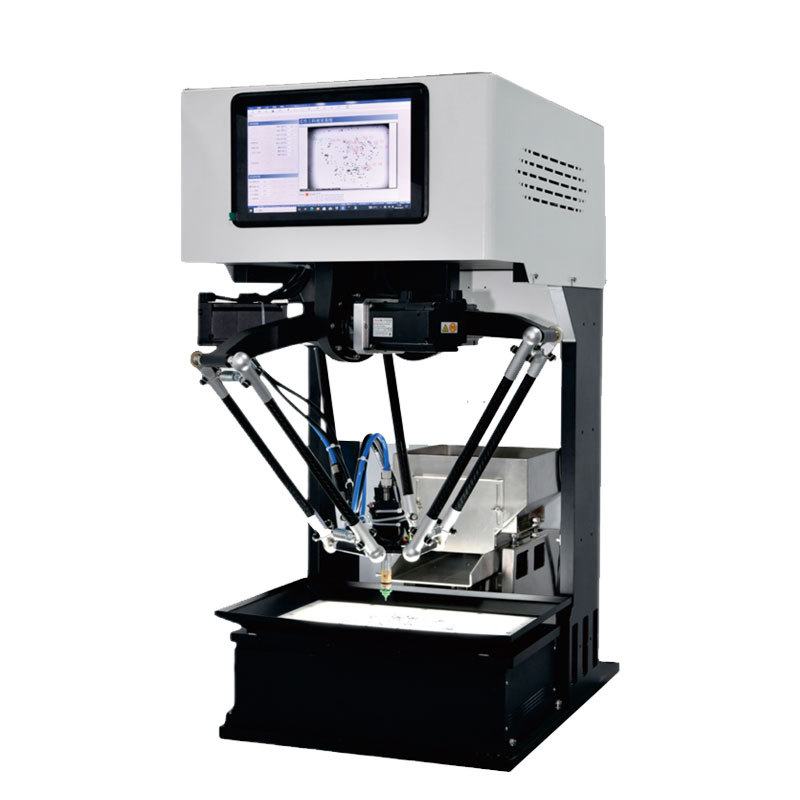

- Цена дельта-робота для сортировки фармацевтической продукции