Производители систем сбора и анализа данных

Когда говорят о производителях систем сбора и анализа данных, часто используют красивые слова про 'интеллектуальный анализ' и 'предиктивную аналитику'. В реальности же все гораздо сложнее и, согласитесь, не всегда гламурно. По моему опыту, большая часть проектов начинается с четкого понимания проблемы – а ее часто нет, или она сформулирована неверно. И тогда любой самый передовой инструмент, даже самый дорогой, бесполезен. Поэтому сейчас пытаюсь сфокусироваться на практической составляющей, на тех сложностях, с которыми сталкиваешься на этапе внедрения.

Проблема сбора данных: 'мусор на входе – мусор на выходе'

Самый распространенный повод для срыва проекта – плохой сбор данных. Качество данных определяет качество анализа, а значит, и ценность полученных выводов. Мы часто видим, как компании вкладываются огромные деньги в сложные системы сбора и анализа данных, но при этом пренебрегают вопросами качества исходной информации. Например, однажды мы работали с компанией, которая собирала данные с датчиков оборудования. Но, оказалось, что данные часто некорректные из-за проблем с калибровкой датчиков и неполной передачи данных. В результате, все аналитические модели выдавали неверные результаты. И это – классика.

Второй распространенный косяк – неправильно подобранные источники данных. Не все данные одинаково полезны. Нужно понимать, какие именно данные необходимы для решения конкретной задачи. Например, если задача – оптимизировать логистику, то полезно собирать данные о перемещениях грузов, времени доставки, загруженности дорог и т.д. Но данные о погоде могут быть нерелевантными, если не учитываются конкретные особенности маршрута. Помню один проект, где пытались прогнозировать спрос на продукцию, используя данные из социальных сетей. Это оказалось полной тратой времени, потому что данные из соцсетей не отражали реальный спрос.

Поэтому, при работе с производителями систем сбора и анализа данных, важно не только оценивать технические характеристики платформы, но и спрашивать их о подходах к валидации и очистке данных. Наличие инструментов для обеспечения качества данных – это критически важно.

Особенности работы с датчиками и IoT

Стремительный рост числа устройств IoT значительно усложнил процесс сбора данных. Особенно сложно бывает обеспечить безопасность и надежность передачи данных с большого количества устройств. Мы часто сталкиваемся с проблемами с масштабируемостью, когда система сбора и анализа данных, разработанная для небольшого количества устройств, не может справиться с растущим объемом данных.

Важным аспектом является выбор протоколов передачи данных. Разные устройства используют разные протоколы, и не всегда их можно легко интегрировать в единую систему. Например, MQTT, CoAP, LoRaWAN – каждый имеет свои преимущества и недостатки. Необходимо тщательно оценивать все факторы и выбирать оптимальный протокол для конкретной задачи.

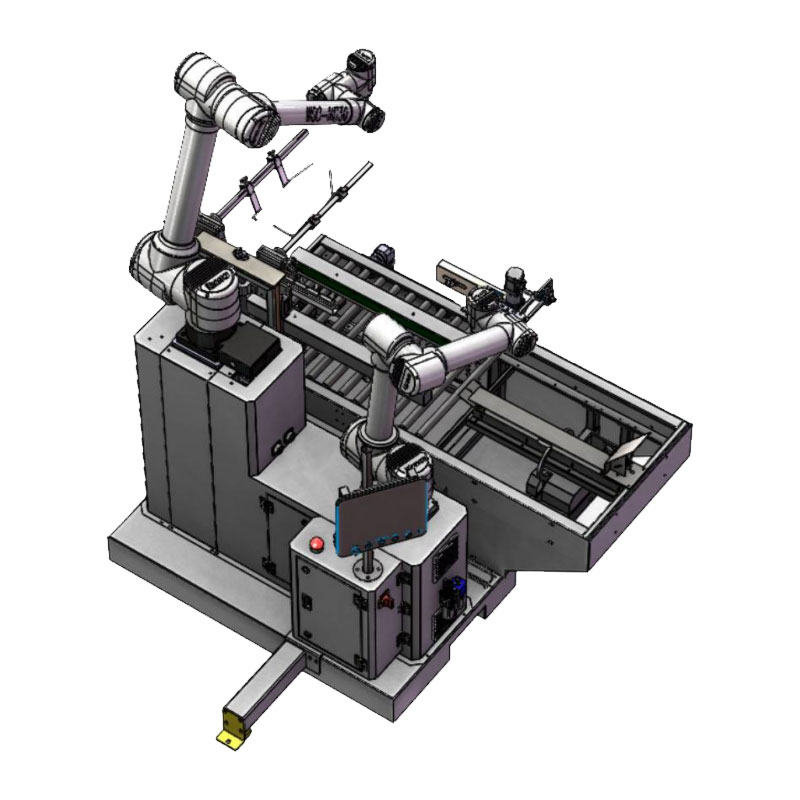

ООО Чэнду Хуашэнконг Технологической компании, согласно их официальному сайту https://www.warsoncorobot.ru, специализируется на разработке интеллектуальных роботов AI, что подразумевает интенсивный сбор и анализ данных с датчиков и камер. Они, вероятно, сталкиваются с теми же проблемами масштабируемости и безопасности, что и многие другие компании, работающие в сфере IoT.

Выбор платформы: 'больше функций – не всегда лучше'

Рынок производителей систем сбора и анализа данных сейчас переполнен разными предложениями. Каждый производитель обещает лучшую систему, но на практике это не всегда так. Важно понимать, что нет универсального решения, которое подходит для всех задач. При выборе платформы необходимо учитывать конкретные требования проекта, бюджет и квалификацию команды.

Часто производители предлагают широкий набор функций, которые не всегда необходимы. Это может привести к переплате и усложнению системы. Лучше выбрать платформу с минимальным набором функций, которые действительно нужны для решения задачи. Например, если задача – просто собирать данные с датчиков и визуализировать их, то не нужно выбирать сложную платформу с функциями машинного обучения и искусственного интеллекта.

Важно оценить гибкость платформы. Насколько легко ее можно настроить под конкретные нужды? Можно ли интегрировать ее с другими системами? Можно ли расширять ее функциональность? Эти вопросы необходимо задать производителю платформы.

Облачные vs. локальные решения

Еще один важный вопрос – выбор между облачным и локальным решением. Облачные решения предлагают масштабируемость и гибкость, но требуют надежного интернет-соединения и могут быть дороже в долгосрочной перспективе. Локальные решения обеспечивают большую безопасность и контроль над данными, но требуют больших инвестиций в инфраструктуру и обслуживание.

Выбор между облачным и локальным решением зависит от многих факторов, включая объем данных, требования к безопасности и бюджет. Некоторым компаниям, например, связанным с обработкой конфиденциальной информации, лучше выбрать локальное решение. Другие же, которым важна масштабируемость и гибкость, предпочтут облачное решение.

ООО Хуашэнконг Интеллектуальные Технологии, судя по их специализации на робототехнике, вероятно, используют комбинацию облачных и локальных решений. Локальные решения, вероятно, применяются для обработки данных в реальном времени на самих роботах, а облачные – для хранения и анализа больших объемов данных, собранных с большого количества роботов.

Интеграция с существующими системами: 'просто так не получится'

Интеграция новой системы сбора и анализа данных с существующими системами – это часто самая сложная и трудоемкая часть проекта. Существующие системы могут быть устаревшими и использовать разные технологии. Необходимо тщательно планировать интеграцию и учитывать все возможные риски.

Часто приходится писать кастомные интеграционные модули, что требует дополнительных затрат времени и ресурсов. Важно использовать стандартизированные интерфейсы и протоколы, чтобы упростить интеграцию. Но даже в этом случае могут возникнуть проблемы, если существующие системы несовместимы друг с другом.

Не стоит недооценивать важность тестирования интеграции. Необходимо тщательно протестировать все интеграционные сценарии, чтобы убедиться, что все системы работают правильно вместе.

Проблемы масштабирования и производительности

По мере роста объема данных и количества пользователей система сбора и анализа данных может начать работать медленнее. Это связано с тем, что существующая инфраструктура может не справляться с возросшей нагрузкой. Необходимо заранее продумать, как будет масштабироваться система, и какие меры будут приняты для обеспечения производительности.

Масштабирование может быть как вертикальным (добавление ресурсов к существующей инфраструктуре), так и горизонтальным (добавление новых серверов). Выбор между вертикальным и горизонтальным масштабированием зависит от многих факторов, включая бюджет и требования к производительности.

Регулярный мониторинг производительности системы и ее оптимизация – это важная задача, которую необходимо решать на постоянной основе. Иначе, система может начать работать очень медленно и стать непригодной для использования.

Соответствующая продукция

Соответствующая продукция.jpg)

Самые продаваемые продукты

Самые продаваемые продукты-

WSC-FJ-ZS800

WSC-FJ-ZS800 -

WSC-MD20Max

WSC-MD20Max -

WSC-MD60Max

WSC-MD60Max -

WSC-300E

WSC-300E -

Чжишэн WSC-600DJ

Чжишэн WSC-600DJ -

Чжикун WSC-400D

Чжикун WSC-400D -

Стандартная машина для упаковки мягких пакетов

Стандартная машина для упаковки мягких пакетов -

WSC-MD16PRO

WSC-MD16PRO -

Универсальная машина для распаковки WSC-KZ-RD60T/-RD60B

Универсальная машина для распаковки WSC-KZ-RD60T/-RD60B -

Универсальная коллаборативная машина для вскрытия и установки WSC-KZ-16/25

Универсальная коллаборативная машина для вскрытия и установки WSC-KZ-16/25 -

WSC-MD40Max

WSC-MD40Max -

Универсальная машина для вскрытия и запечатывания WSC-KZF-RD60T/-RD60B

Универсальная машина для вскрытия и запечатывания WSC-KZF-RD60T/-RD60B

Связанный поиск

Связанный поиск- OEM Картонирование робот рука

- Поставщики датчиков скорости

- Купить Автоматизация склада

- Сортировка с помощью машинного зрения

- Превосходные системы управления ЧПУ

- Захват трехмерного изображения в Китае

- Поставщики роботов для распаковки

- Обнаружение столкновений в Китае

- Оптовая робототехника

- Поставщики роботизированных систем визуального распознавания