Сбор и анализ данных оптом

Итак, сбор и анализ данных оптом – звучит масштабно, правильно? Большинство людей представляют себе огромные объемы информации, словно океан, который нужно каким-то образом исследовать. Но на практике все оказывается куда сложнее и интереснее. Особенно когда дело доходит до построения эффективной системы. Говоря честно, я часто вижу, как компании бросаются в омут с головой, покупают кучу инструментов, а потом буксуют, потому что не понимают, с чего начать, какие данные собирать и как их правильно интерпретировать. Кажется, что всё просто, но это далеко не так. Сегодня хочу поделиться своим опытом, а может, и ошибками, чтобы, надеюсь, хоть немного помочь вам разобраться в этой непростой теме.

Первый шаг: определение целей и задач

Это, пожалуй, самый важный этап, который часто упускают. Прежде чем думать о технологиях и инструментах, нужно четко понимать, зачем вам сбор и анализ данных оптом вообще нужен. Что вы хотите получить в итоге? Какие бизнес-задачи решить? Например, оптимизировать логистику, улучшить качество продукции, персонализировать маркетинг? От ответа на эти вопросы будет зависеть весь дальнейший процесс. Без четкой цели рискуете просто захламлять себя информацией, которую потом не сможете эффективно использовать.

Мы сталкивались с ситуацией, когда крупный производитель, планируя внедрение системы сбора и анализа данных оптом, хотел получить 'все данные о потребителях'. Решили собрать информацию о продажах, демографии, предпочтениях... В итоге получили гору данных, которые никто не использовал. Оказалось, что им нужна была конкретная информация о покупательском поведении в определенном сегменте рынка, а не просто общая картина.

Определение ключевых показателей эффективности (KPI)

Определившись с целью, необходимо определить KPI. Что именно будет отслеживаться? Какие метрики покажут, что вы двигаетесь в правильном направлении? Например, для логистики это может быть время доставки, стоимость транспортировки, процент поврежденных грузов. Для маркетинга - конверсия, стоимость привлечения клиента, LTV (lifetime value). Важно, чтобы KPI были измеримыми и отражали реальный бизнес-результат.

Во время работы с одной из крупных логистических компаний, мы вместе с ними определили KPI – сокращение времени доставки на 15% и снижение стоимости транспортировки на 10%. Это стало нашим ориентиром при выборе инструментов и построении системы сбора и анализа данных оптом. И, кстати, мы достигли этих целей.

Технологии и инструменты: обзор

Существует огромное количество инструментов для сбора и анализа данных оптом. Они различаются по функциональности, стоимости и сложности использования. Можно использовать как готовые платформы (например, Tableau, Power BI, Qlik Sense), так и разрабатывать собственные решения с использованием языков программирования (Python, R) и баз данных (SQL, NoSQL). Выбор зависит от ваших потребностей и возможностей.

Мы часто используем комбинацию инструментов. Например, для сбора данных используем API различных сервисов, такие как Яндекс.Метрика, Google Analytics, CRM-системы. Для хранения данных используем облачные хранилища (AWS, Azure, Google Cloud). Для анализа – Python и библиотеки Pandas, NumPy, Scikit-learn. А для визуализации – Tableau.

Сбор данных из различных источников

Одним из основных вызовов при сборе и анализе данных оптом является получение данных из разных источников. Данные могут храниться в CRM-системах, ERP-системах, базах данных, файлах Excel, Google Sheets, социальных сетях и т.д. Необходимо разработать систему для автоматического сбора и интеграции данных из этих источников.

В одном из проектов у нас была задача интегрировать данные из устаревшей CRM-системы, написанной на PHP, и современной CRM-системы, построенной на Salesforce. Это оказалось непростой задачей, так как системы использовали разные форматы данных и разные методы аутентификации. Пришлось написать скрипты для преобразования данных и обеспечения безопасного доступа к обеим системам.

Особенности работы с большими данными

Когда речь идет о сборе и анализе данных оптом, мы часто сталкиваемся с проблемой больших объемов данных. Это создает дополнительные сложности с хранением, обработкой и анализом данных. Необходимы специальные технологии и инструменты для работы с большими данными (например, Hadoop, Spark).

Мы однажды пытались использовать стандартные инструменты для анализа данных, но столкнулись с серьезными проблемами с производительностью. Система просто 'зависала' при попытке обработать большие объемы данных. Пришлось перейти на Spark, который оказался намного эффективнее. Это был очень ценный опыт.

Выбор правильной базы данных

Правильный выбор базы данных – это критически важный фактор для сбора и анализа данных оптом. База данных должна быть способна хранить большие объемы данных, обеспечивать высокую скорость доступа к данным и поддерживать необходимые типы запросов. Для хранения структурированных данных обычно используют реляционные базы данных (SQL), а для хранения неструктурированных данных – NoSQL базы данных.

В зависимости от конкретных задач, мы часто выбираем различные типы баз данных. Например, для хранения транзакционных данных используем PostgreSQL, а для хранения неструктурированных данных – MongoDB.

Анализ данных: от описательного к предиктивному

Анализ данных можно разделить на несколько уровней. Начальный уровень – это описательный анализ, который позволяет понять, что произошло в прошлом. Более продвинутый уровень – это диагностический анализ, который позволяет выявить причины произошедшего. А самый продвинутый уровень – это предиктивный анализ, который позволяет предсказать, что произойдет в будущем.

Мы часто используем машинное обучение для предиктивного анализа. Например, для прогнозирования спроса на продукцию, для выявления мошеннических операций, для персонализации рекомендаций.

Визуализация данных: ключ к пониманию

Визуализация данных – это важный инструмент для понимания результатов анализа. Визуализация данных позволяет представить сложные данные в понятной и наглядной форме. Существует множество различных типов визуализаций – графики, диаграммы, карты, дашборды. Важно выбрать правильный тип визуализации для каждого случая.

Мы всегда стараемся использовать визуализации данных для представления результатов анализа перед заказчиками. Это позволяет им быстрее понять ключевые выводы и принять правильные решения.

В заключение: постоянное развитие

Сбор и анализ данных оптом – это непрерывный процесс, который требует постоянного развития и совершенствования. Технологии постоянно меняются, появляются новые инструменты и методы анализа данных. Важно быть в курсе последних тенденций и не бояться экспериментировать. И главное – не забывать о цели, ради которой вы начали этот процесс. Ведь только так можно получить реальную пользу от анализа данных.

Мы сами постоянно учимся и развиваемся, изучаем новые инструменты и методы анализа данных. И стараемся делиться своими знаниями с другими.

Соответствующая продукция

Соответствующая продукция.jpg)

Самые продаваемые продукты

Самые продаваемые продукты-

Стандартная машина для упаковки мягких пакетов

Стандартная машина для упаковки мягких пакетов -

Чжихуа WSC-600D

Чжихуа WSC-600D -

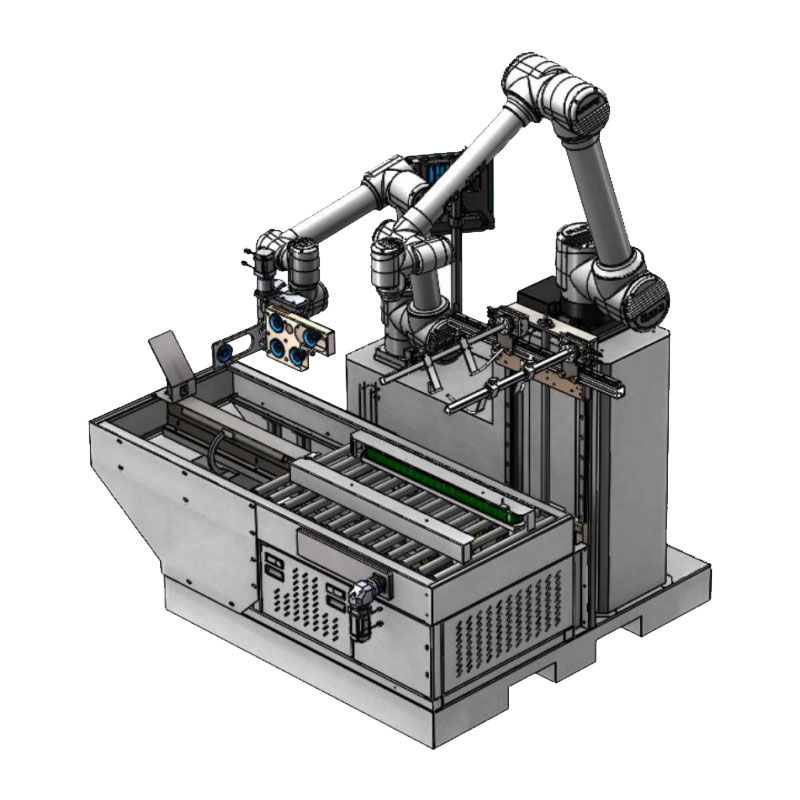

Универсальная коллаборативная машина для вскрытия и установки WSC-KZ-16125

Универсальная коллаборативная машина для вскрытия и установки WSC-KZ-16125 -

Чжихуа WSC-1000D

Чжихуа WSC-1000D -

WSC-MD30PRO

WSC-MD30PRO -

Чжикун WSC-400D

Чжикун WSC-400D -

WSC-MD20Max

WSC-MD20Max -

WSC-ZX1000D

WSC-ZX1000D -

Чжихуа WSC-800D

Чжихуа WSC-800D -

WSC-MD25Max

WSC-MD25Max -

Универсальная машина для распаковки WSC-KZ-RD60T/-RD60B

Универсальная машина для распаковки WSC-KZ-RD60T/-RD60B -

Чжишэн WSC-1000DJ

Чжишэн WSC-1000DJ

Связанный поиск

Связанный поиск- Цена автоматизации склада

- Системы поиска и устранения неисправностей

- Установки для автоматизированных сортировочных машин

- Производитель роботизированного слияния визуальных датчиков

- Фабрики технологий IoT

- Отличная интеллектуальная сортировка

- Производство автоматических термоусадочных упаковочных машин

- OEM Картонирование робот рука

- Гибкие погрузочно-разгрузочные работы в Китае

- Дешевые цифровые двойники