Цена сбора и анализа данных

Поговорим начистоту. Когда клиенты спрашивают про стоимость сбора и анализа данных, в голове сразу возникают разные картинки: от астрономических сумм, требующих кредита, до 'бесплатных' решений, которые потом выпрашивают дополнительных денег за 'поддержку' или 'расширенную функциональность'. Правда, как всегда, где-то посередине. Реальность – она гораздо сложнее и зависит от кучи факторов, и часто эти факторы не очевидны сразу. Например, часто недооценивают время на подготовку данных. А это, как правило, самая затратная часть, хотя многие считают, что просто нужно подключить какой-нибудь сервис и получить готовые результаты. Их ожидания, как правило, сильно отличаются от того, что реально получается.

Факторы, влияющие на стоимость

Стоимость проекта по сбору и анализу данных – это не просто умножение цены за час работы аналитика на количество часов. Здесь целый комплекс факторов играет роль. Первое – это объем и разнородность данных. Очевидно, что анализ нескольких электронных таблиц будет стоить гораздо дешевле, чем обработка терабайтов данных из разных источников, включая данные с датчиков, лог-файлы и данные из социальных сетей. Второе – это сложность задачи. Простая визуализация данных – это одно, а построение сложной модели машинного обучения – совсем другое. Третье – это необходимая инфраструктура. Нужны ли облачные ресурсы, специализированное оборудование, лицензионное ПО? Ну и, конечно, квалификация команды. Опытный специалист, способный быстро найти решение, будет стоить дороже, чем начинающий аналитик, которому потребуется больше времени на обучение и эксперименты.

Мы в ООО Чэнду Хуашэнконг Технологической компании (https://www.warsoncorobot.ru/) имеем достаточно большой опыт работы в этой сфере. Мы часто сталкиваемся с ситуациями, когда клиенты изначально занижают оценку трудозатрат, а потом удивляются, когда конечная стоимость проекта значительно превышает их первоначальный бюджет. Часто это связано с нереалистичными ожиданиями относительно скорости получения результатов. Клиент хочет 'волшебной таблетки', которая решит все проблемы, но на деле нужен кропотливый труд и итеративный подход. Например, однажды мы работали над проектом по оптимизации логистической сети для крупной транспортной компании. Изначально клиент ожидал получить готовый отчет с рекомендациями за неделю. В итоге, процесс анализа данных, очистки, преобразования и построения модели оптимизации занял почти два месяца. Это был довольно болезненный урок, который мы усвоили, и сейчас стараемся максимально реалистично оценивать сроки и стоимость работ.

Типы затрат при сборе и анализе данных

Если говорить о конкретных статьях затрат, то можно выделить несколько основных. Во-первых, это затраты на сбор данных. Это может быть оплата API-доступа к сервисам, которые предоставляют данные, покупка данных у сторонних поставщиков, или, в некоторых случаях, затраты на разработку собственных инструментов для сбора данных. Во-вторых, это затраты на хранение данных. Объем данных постоянно растет, и для их хранения требуются соответствующие ресурсы. В-третьих, это затраты на обработку и анализ данных. Это включает в себя затраты на программное обеспечение, вычислительные ресурсы и оплату труда аналитиков. В-четвертых, это затраты на визуализацию и отчетность. Важно не только проанализировать данные, но и представить результаты в понятной и наглядной форме.

Особо стоит упомянуть о затратах на качество данных. Некачественные данные – это кошмар любого аналитика. Поэтому необходимо уделять достаточно времени и ресурсов очистке и валидации данных. В нашем случае, мы часто сталкиваемся с проблемами, связанными с неполными или некорректными данными. Например, данные о клиентах могут быть устаревшими или содержать ошибки, что приводит к искаженным результатам анализа. Для решения этих проблем мы используем различные методы очистки и преобразования данных, а также разрабатываем собственные алгоритмы для обнаружения и исправления ошибок.

Сбор данных из различных источников

Современный мир предоставляет огромное количество источников данных. От социальных сетей и онлайн-магазинов до датчиков IoT и медицинских карт. И каждый из этих источников имеет свои особенности и требует своего подхода к сбору и обработке. Например, сбор данных из социальных сетей часто требует использования API и соблюдения правил конфиденциальности. Сбор данных с датчиков IoT может потребовать установки специальных устройств и настройки инфраструктуры. А сбор данных из медицинских карт требует соблюдения строгих правил защиты персональных данных.

Вопрос о том, какой подход выбрать для сбора данных, зависит от конкретной задачи и доступных ресурсов. Мы часто используем комбинацию различных методов сбора данных, чтобы получить максимально полную и достоверную информацию. Например, мы можем использовать API для сбора данных из социальных сетей, а также проводить опросы и интервью с пользователями, чтобы получить дополнительную информацию.

Инструменты и технологии

Существует огромное количество инструментов и технологий для сбора и анализа данных. От простых электронных таблиц и статистических пакетов до сложных облачных платформ и инструментов машинного обучения. Выбор подходящего инструмента зависит от сложности задачи и доступных ресурсов. Для простых задач можно использовать Excel или Google Sheets. Для более сложных задач можно использовать Python с библиотеками Pandas, NumPy и Scikit-learn. Для работы с большими данными можно использовать облачные платформы, такие как Amazon Web Services (AWS), Google Cloud Platform (GCP) или Microsoft Azure. А для построения моделей машинного обучения можно использовать специализированные инструменты, такие как TensorFlow или PyTorch.

Мы в ООО Чэнду Хуашэнконг Технологической компании используем широкий спектр инструментов и технологий для сбора и анализа данных. Мы часто используем облачные платформы AWS и GCP для работы с большими данными. Мы также используем Python с библиотеками Pandas, NumPy и Scikit-learn для построения моделей машинного обучения. Кроме того, мы используем различные инструменты для визуализации данных, такие как Tableau и Power BI.

Рекомендации по оптимизации затрат

Несмотря на то, что стоимость сбора и анализа данных может быть достаточно высокой, есть несколько способов оптимизировать затраты. Во-первых, необходимо четко определить цели проекта и scope работ. Во-вторых, необходимо правильно оценить объем и разнородность данных. В-третьих, необходимо выбрать подходящие инструменты и технологии. В-четвертых, необходимо уделять достаточно времени и ресурсов очистке и валидации данных. В-пятых, необходимо использовать итеративный подход к работе, чтобы постепенно улучшать результаты анализа.

Например, мы рекомендуем начинать с небольшого пилотного проекта, чтобы оценить сложность задачи и объем необходимых ресурсов. Это позволит избежать неожиданных затрат и оптимизировать бюджет проекта. Кроме того, мы рекомендуем использовать готовые решения и инструменты, когда это возможно, чтобы сэкономить время и ресурсы. Наконец, мы рекомендуем постоянно отслеживать результаты проекта и вносить необходимые корректировки.

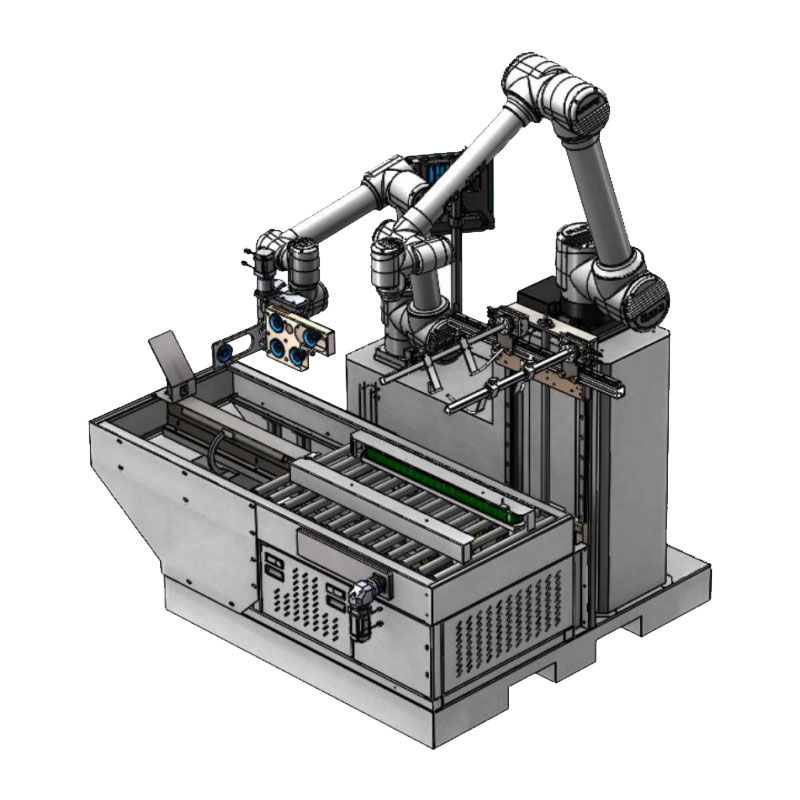

Соответствующая продукция

Соответствующая продукция.jpg)

Самые продаваемые продукты

Самые продаваемые продуктыСвязанный поиск

Связанный поиск- OEM интеграция конечных линий

- Фабрика приложений IoT

- Оптовая упаковка сортировщик

- Автоматизация производственных процессов оптом

- Поставщики оборудования для обработки и упаковки пищевых продуктов

- Ведущий покупатель автоматизированной распаковки

- OEM промышленные чипы

- OEM паллетирование и картонирование машины

- Оптовая торговля промышленной робототехникой

- Системы управления ЧПУ в Китае