OEM Сбор и анализ данных

Сбор и анализ данных – это, казалось бы, тривиальное понятие. Зачастую, в разговорах об автоматизации производства или внедрении роботизированных систем, это упоминается как 'дано'. Но когда дело доходит до практической реализации, всплывают вопросы, о которых редко говорят публично. Помню, как на одной из первых разработок для логистического центра мы столкнулись с ошеломляющим объемом данных, просто 'выдающимся' из разных источников: датчики на конвейерах, камеры видеонаблюдения, информация из WMS-системы, данные о загрузке и расписании. И вот тут началось самое интересное – попытка связать эти разрозненные потоки в единую картину. И это далеко не всегда оказывается простым 'сбором'.

Проблема разнородности и качества данных

Первая реальная проблема, с которой сталкиваешься – это разнородность источников. Данные о скорости перемещения объектов, данные о траектории движения робота, данные о состоянии оборудования – все это представлено в разных форматах, с разной частотой обновления и, что самое неприятное, с разным уровнем точности. Часто приходилось проводить значительные усилия по стандартизации форматов, очистке данных от пропусков и выбросов. И тут, знаете, начинается настоящий инженерный поиск – как построить pipeline, который будет корректно обрабатывать эту 'мусорную кучу'. Сбор и анализ данных без предварительной подготовки – это как пытаться собрать пазл из разломанных деталей.

В одном проекте для крупного склада, мы потратили месяцы на выявление и исправление ошибок в данных о количестве товаров на складе. Оказалось, что разные сканеры при сканировании штрихкодов выдавали разные значения из-за разного освещения и угла обзора. Пришлось разрабатывать алгоритмы коррекции ошибок и калибровки сканеров. Это, конечно, увеличило стоимость проекта, но позволило существенно повысить точность последующего анализа.

Очистка и предобработка данных: невидимый, но критически важный этап

Не стоит недооценивать этап предобработки данных. Здесь нужно не просто убрать очевидный мусор, но и заполнить пропуски, обработать выбросы, преобразовать данные в удобный формат для последующего анализа. Для этого используются различные методы: среднее значение, медиана, интерполяция, алгоритмы машинного обучения. Выбор метода зависит от типа данных и характера пропусков. Ключевой момент – это понимание бизнес-логики и контекста данных.

Например, если датчик температуры на оборудовании выдал неверное значение, простое закрашивание этого значения средним значением может привести к серьезным ошибкам в диагностике. В таких случаях, лучше использовать более сложные алгоритмы, которые учитывают зависимости между разными параметрами.

Выбор инструментов и технологий

Выбор инструментов для сбора и анализа данных зависит от множества факторов: объема данных, требуемой скорости обработки, сложности задач анализа, бюджета проекта. На начальном этапе часто используются простые инструменты, такие как Python с библиотеками Pandas и NumPy, SQL-запросы. Но по мере роста объема данных и сложности задач, необходимо переходить к более мощным платформам.

Мы в ООО Чэнду Хуашэнкун Технологической компании (https://www.warsoncorobot.ru/) часто сталкиваемся с необходимостью обработки больших объемов данных, полученных от роботизированных систем. В таких случаях мы используем облачные платформы, такие как AWS, Azure или Google Cloud Platform. Они предоставляют широкий спектр инструментов для сбора, хранения, обработки и анализа данных. Но, разумеется, выбор платформы должен быть обоснован и соответствовать конкретным требованиям проекта.

Прямые подключения к источникам данных и ETL-процессы

В идеале, сбор и анализ данных должны быть интегрированы в единый процесс, который позволяет автоматически собирать данные из различных источников, преобразовывать их и загружать в централизованное хранилище. Для этого используются ETL-инструменты (Extract, Transform, Load). Они позволяют автоматизировать процесс подготовки данных для анализа и упростить интеграцию данных из разных источников.

Мы применяли ETL-процессы для интеграции данных с разных роботизированных систем, чтобы получить единую картину производительности и состояния оборудования. Это позволило нам выявлять узкие места в производственном процессе и оптимизировать работу роботов.

Анализ данных и визуализация результатов

После того, как данные собраны и подготовлены, можно приступать к их анализу. Здесь используются различные методы: статистический анализ, машинное обучение, data mining. Цель анализа – выявить закономерности, тренды, аномалии в данных и сделать на их основе выводы. Результаты анализа обычно визуализируются в виде графиков, диаграмм, дашбордов.

Мы часто используем инструменты визуализации данных, такие как Tableau или Power BI, для создания интерактивных дашбордов, которые позволяют пользователям отслеживать ключевые показатели производительности и состояние оборудования в режиме реального времени. Это особенно полезно для операторов и инженеров, которые должны быстро реагировать на изменения в производственном процессе.

Применение машинного обучения для предиктивной аналитики

В последние годы все большую популярность приобретает применение машинного обучения для сбора и анализа данных. Алгоритмы машинного обучения позволяют прогнозировать будущее поведение системы на основе исторических данных. Например, можно прогнозировать поломки оборудования, оптимизировать расписание работы роботов, улучшить качество продукции.

ООО Хуашэнконг Интеллектуальные Технологии активно разрабатывает решения на базе машинного обучения для оптимизации работы роботизированных систем. Мы используем различные алгоритмы машинного обучения, такие как регрессия, классификация, кластеризация и нейронные сети. Но важно помнить, что для успешного применения машинного обучения необходимо иметь достаточное количество качественных данных.

Ошибки и подводные камни

Нельзя избежать обсуждения возможных проблем. Сбор и анализ данных – это не волшебная палочка, которая решит все проблемы. Существует множество подводных камней, о которых нужно знать. Например, одной из распространенных ошибок является переоценка возможностей данных. Не всегда данные могут предоставить полную картину происходящего.

В одном из проектов мы потратили много времени и усилий на анализ данных о производительности роботов, но не учли влияние внешних факторов, таких как изменения в технологическом процессе или качественном сырье. Это привело к неверным выводам и неправильным решениям. Поэтому, важно всегда критически оценивать данные и не делать поспешных выводов.

Безопасность и конфиденциальность данных

Еще одна важная проблема – это безопасность и конфиденциальность данных. Данные о производственном процессе, финансовой деятельности и интеллектуальной собственности должны быть защищены от несанкционированного доступа. Для этого используются различные методы: шифрование данных, контроль доступа, аудит.

В связи с ростом числа кибератак, обеспечение безопасности данных становится все более важной задачей. ООО Чэнду Хуашэнкун Технологической компании уделяет особое внимание вопросам безопасности данных, и мы постоянно совершенствуем наши методы защиты.

В заключение хочу сказать, что сбор и анализ данных – это сложный и многогранный процесс, который требует знаний, опыта и постоянного совершенствования. Но при правильном подходе, он может принести огромную пользу бизнесу. Главное - не забывать о практической реализации, не терять связь с реальными задачами и всегда критически оценивать полученные результаты.

Соответствующая продукция

Соответствующая продукция.jpg)

Самые продаваемые продукты

Самые продаваемые продукты-

WSC-MD30Max

WSC-MD30Max -

Чжишэн WSC-1000DJ

Чжишэн WSC-1000DJ -

WSC-MD16Max

WSC-MD16Max -

WSC-ZX1000D

WSC-ZX1000D -

WSC-MD25Max

WSC-MD25Max -

Высокоскоростная машина для упаковки мягких пакетов

Высокоскоростная машина для упаковки мягких пакетов -

Универсальная машина для распаковки WSC-KZ-RD60T/-RD60B

Универсальная машина для распаковки WSC-KZ-RD60T/-RD60B -

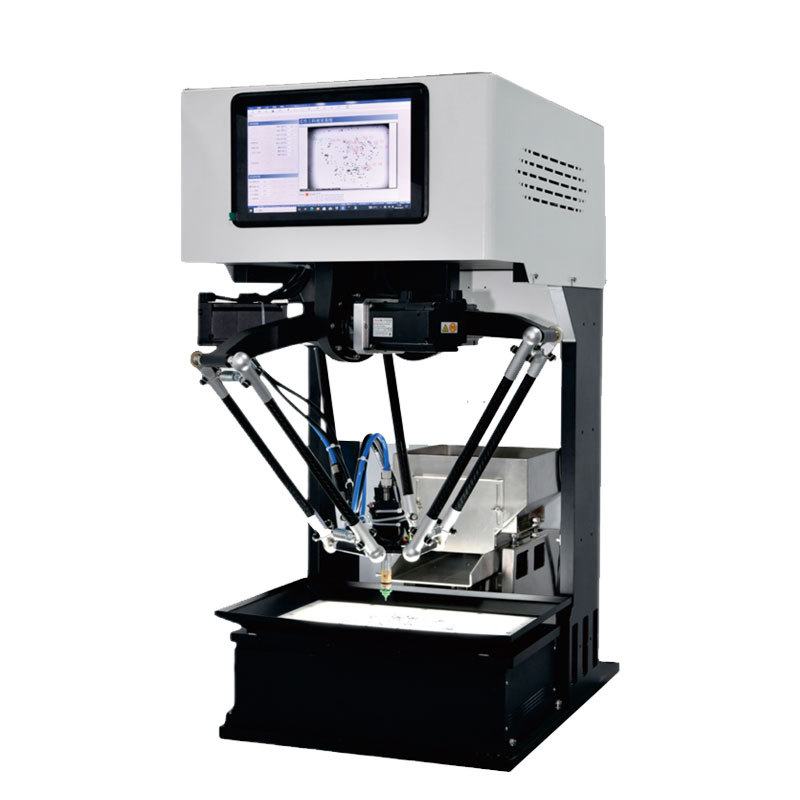

Зрение робота

Зрение робота -

WSC-MD40PRO

WSC-MD40PRO -

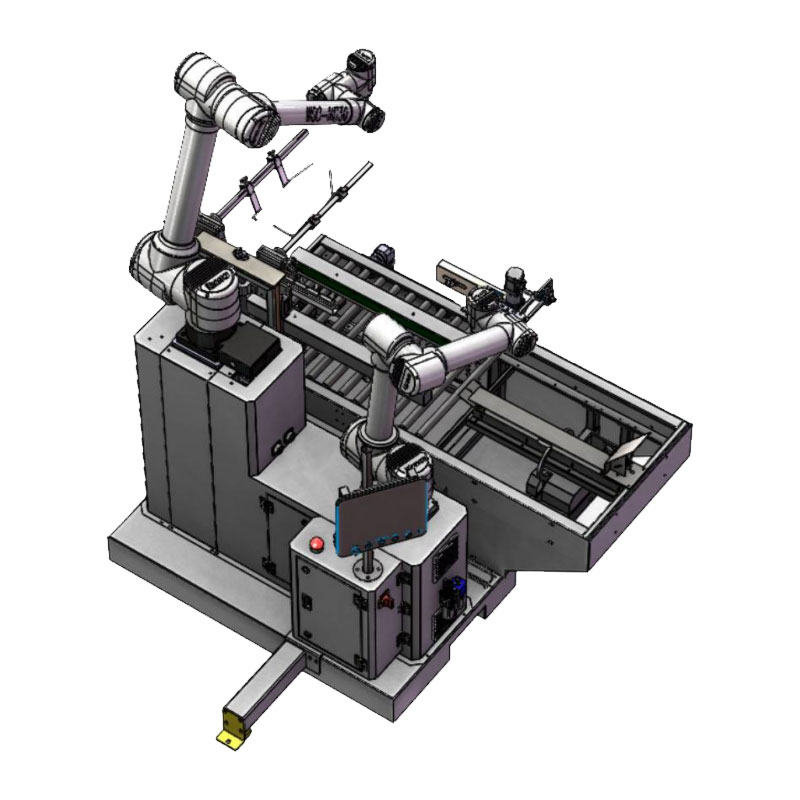

Универсальная коллаборативная машина для вскрытия и установки WSC-KZ-16/25

Универсальная коллаборативная машина для вскрытия и установки WSC-KZ-16/25 -

WSC-MD25PRO

WSC-MD25PRO -

Чжихуа WSC-600D

Чжихуа WSC-600D

Связанный поиск

Связанный поиск- Датчики камер в Китае

- Страна происхождения роботизированных манипуляторов для паллетирования

- Установки для гибкой обработки грузов

- Цена робототехники

- Управление цепочкой поставок

- Цены на оборудование для автоматизации сборки

- Использование параллельных роботов в качестве ведущих

- Дешевые автоматические паллетизаторы

- Поставщики датчиков скорости

- Системы распаковки в Китае